Windows Server 2025 - HARDWAREANFORDERUNGEN - Ich habe da einige Fragen

Moin Zusammen,

wie ihr vielleicht schon in dem folgenden Beitrag von @Th0mKa gelesen habt ...

Windows Server 2025 verfügbar

... ist bei Microsoft die Tage der neuste Server 2025 offiziell herausgeschlüpft.

Und so habe ich gestern Abend noch geschwind den Download der ISO's angestossen und habe heute Morgen mit Absicht einen bestimmten Lab-Server für einen Installationsversuch wieder entstaubt. 😁

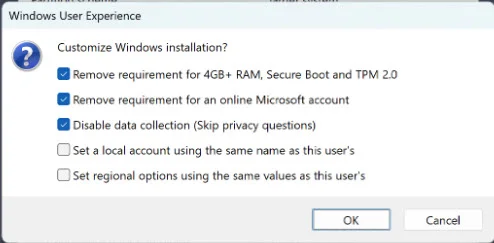

Der Installations-Stick war mit der aktuellen RuFus Version und ohne jegliche Probleme ratz fatz erstellt ...

rufus.ie/de/

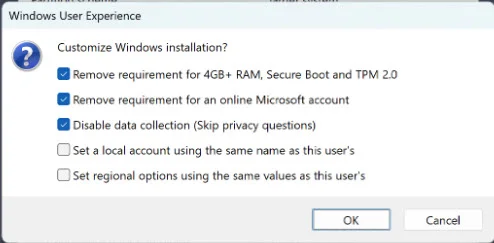

... und ich habe mit Absicht auch KEINE der folgenden Optionen aktiviert ...

... sprich, nur einen ganz gewöhnlichen Installations-Stick erstellt.

Dann habe ich den Stick in den angesprochenen Server gesteckt, diesen eingeschaltet und konnte ohne jegliche Probleme, Warnungen oder Fehlermeldungen, den Server 2025 installieren. 🙃

Nun wird sich der eine oder andere denken … OK … und was sollt nun das Ganze.

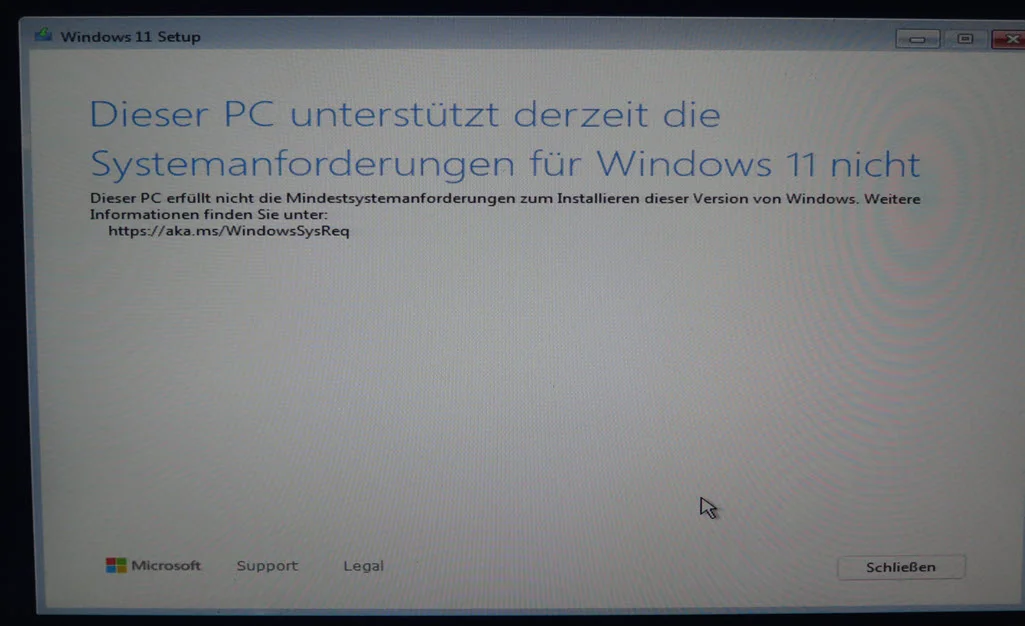

Geduld, denn zuerst möchte ich noch auf eine Kleinigkeit eingehen, die sehr vielen und auch mir, schon beim Erscheinen von Windows 11 etwas sauer aufgetrossen ist. 😔

Und zwar dessen weitestgehend nicht nachvollziehbare Hardwareanforderungen, insbesondere die für die „supporteten“ CPU’s. 😭

Denn laut Microsoft, benötigt man für einen Windows 11 Rechner mindestens eine „8th Generation Intel Core Series“ CPU, also eine CPU anno 2017, damit ein Windows 11 auch ja sicher auf dieser Hardware laufen kann.

Windows-Prozessoranforderungen: Unter Windows 11 unterstützte Intel-Prozessoren | Microsoft Learn

Ähm ja, ich habe ja oben schon geschrieben, dass ich den entsprechenden Server etwas entstauben musste … na ja, das liegt mitunter daran, dass dieser noch mit zwei Intel Xeon E5 2690 V2 CPU’s bestückt ist, sprich, CPU’s anno 2013.

Und ja, ich habe soeben bei der Installation des aktuellsten Server 2025, nicht eine einzige Warnmeldung, wegen irgendwelcher veralteten Hardware bekommen. 😖

Kann mir vielleicht jemand plausibel den Sinn dahinter erklären, also den hinter den Hardwareanforderungen von Microsoft, danke.

Oder werden diese etwa nur gewürfelt? 🤔

Gruss Alex

wie ihr vielleicht schon in dem folgenden Beitrag von @Th0mKa gelesen habt ...

Windows Server 2025 verfügbar

... ist bei Microsoft die Tage der neuste Server 2025 offiziell herausgeschlüpft.

Und so habe ich gestern Abend noch geschwind den Download der ISO's angestossen und habe heute Morgen mit Absicht einen bestimmten Lab-Server für einen Installationsversuch wieder entstaubt. 😁

Der Installations-Stick war mit der aktuellen RuFus Version und ohne jegliche Probleme ratz fatz erstellt ...

rufus.ie/de/

... und ich habe mit Absicht auch KEINE der folgenden Optionen aktiviert ...

... sprich, nur einen ganz gewöhnlichen Installations-Stick erstellt.

Dann habe ich den Stick in den angesprochenen Server gesteckt, diesen eingeschaltet und konnte ohne jegliche Probleme, Warnungen oder Fehlermeldungen, den Server 2025 installieren. 🙃

Nun wird sich der eine oder andere denken … OK … und was sollt nun das Ganze.

Geduld, denn zuerst möchte ich noch auf eine Kleinigkeit eingehen, die sehr vielen und auch mir, schon beim Erscheinen von Windows 11 etwas sauer aufgetrossen ist. 😔

Und zwar dessen weitestgehend nicht nachvollziehbare Hardwareanforderungen, insbesondere die für die „supporteten“ CPU’s. 😭

Denn laut Microsoft, benötigt man für einen Windows 11 Rechner mindestens eine „8th Generation Intel Core Series“ CPU, also eine CPU anno 2017, damit ein Windows 11 auch ja sicher auf dieser Hardware laufen kann.

Windows-Prozessoranforderungen: Unter Windows 11 unterstützte Intel-Prozessoren | Microsoft Learn

Ähm ja, ich habe ja oben schon geschrieben, dass ich den entsprechenden Server etwas entstauben musste … na ja, das liegt mitunter daran, dass dieser noch mit zwei Intel Xeon E5 2690 V2 CPU’s bestückt ist, sprich, CPU’s anno 2013.

Und ja, ich habe soeben bei der Installation des aktuellsten Server 2025, nicht eine einzige Warnmeldung, wegen irgendwelcher veralteten Hardware bekommen. 😖

Kann mir vielleicht jemand plausibel den Sinn dahinter erklären, also den hinter den Hardwareanforderungen von Microsoft, danke.

Oder werden diese etwa nur gewürfelt? 🤔

Gruss Alex

Bitte markiere auch die Kommentare, die zur Lösung des Beitrags beigetragen haben

Content-ID: 669215

Url: https://administrator.de/knowledge/windows-server-2025-hardwareanforderungen-ich-habe-da-einige-fragen-669215.html

Ausgedruckt am: 29.07.2025 um 21:07 Uhr

44 Kommentare

Neuester Kommentar

Zitat von @MysticFoxDE:

Kann mir vielleicht jemand plausibel den Sinn dahinter erklären, also den hinter den Hardwareanforderungen von Microsoft, danke.

Kann mir vielleicht jemand plausibel den Sinn dahinter erklären, also den hinter den Hardwareanforderungen von Microsoft, danke.

Moin,

Ist doch ganz einfach. Microsoft will dir so den Umstieg auf Linux schmackhaft machen.

Gruß

Uwe

Moin.

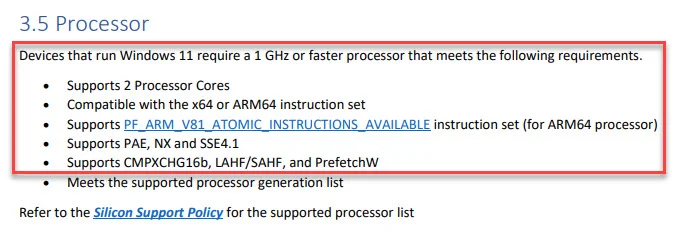

Im Endeffekt kannst du da alle Core i ab Nehalem ohne Fehlermeldung im Setup rein stecken, da ab da das POPCNT Feature integriert wurde.

Jetzt wo Intel aus dem DOW geflogen ist , muss man ja wieder das Geschäft ankurbeln.

Gruß catrell

Im Endeffekt kannst du da alle Core i ab Nehalem ohne Fehlermeldung im Setup rein stecken, da ab da das POPCNT Feature integriert wurde.

Kann mir vielleicht jemand plausibel den Sinn dahinter erklären

Was macht in Redmond schon Sinn🤪. Ein Sesselfurzer-Geplänkel zwischen nem MS Hirni und nem Intel-CEO wird sich das wohl ausgedacht haben um mehr 💲💲 zu generieren.Jetzt wo Intel aus dem DOW geflogen ist , muss man ja wieder das Geschäft ankurbeln.

Gruß catrell

Moin @MysticFoxDE (Level 5)*

Ja: Geld, Geld, Geld........

Kreuzberger

Boah, es gibt hier einen „Level 5“!

🙇♂️

Kann mir vielleicht jemand plausibel den Sinn dahinter erklären, also den hinter den Hardwareanforderungen von Microsoft, danke.

Ja: Geld, Geld, Geld........

Kreuzberger

Boah, es gibt hier einen „Level 5“!

🙇♂️

???

Es gibt doch eine Vielzahl von alten Hasen wie @aqui, @Lochkartenstanzer und wie sie alle heißen - UND eben @MysticFoxDE! Was ist daran jetzt besonders?

Viele Grüße

HansDampf06

Ist doch ganz einfach. Microsoft will dir so den Umstieg auf Linux schmackhaft machen. face-wink

Ehrlich gesagt haben die auch schon, abhängig von der Distribution mehr mal weniger lange, als Mindestanforderung an die CPU, dass sie x86-64-v2-Kompatibel ist. Das entspricht der CPU-Familie Intel Nehalem.

Hintergrund ist, dass man Software so kompilieren kann, dass diese das Vorhandensein bestimmter CPU-Funktionen (z.B. SSE4) als immer vorhanden annehmen kann, was die Software tatsächlich schneller und den Code deutlich übersichtlicher macht. Und die Binary ist weniger anstrengend zu debuggen, wenn sie sich nicht auf jeder Hardware anders verhält.

Mittlerweile wird aber sogar im Linux-Ökosystem v2 von immer mehr Distributionen abgekündigt, Redhat beispielsweise unterstützt mit RHEL 10 offiziell nur noch x86-64-v3 und besser. Das entspricht der CPU-Familie Haswell.

Die Gründe sind hier wieder die gleichen: Wenn sich Software darauf verlassen kann, bestimmte CPU-Funktionen (z.B. AVX) immer vorzufinden, läuft sie besser.

Dass Microsoft jetzt x86-64-v4 als Mindestvoraussetzung nennt ist sportlich, aber diese Architektur ist andererseits bereits 2017 herausgekommen, dürfte also aktuell in Hardware vorzufinden sein die bis zu sieben Jahre alt ist.

Für Serverhardware ist das schon ein stolzes Alter.

Der Hintergrund hier könnte aber sein, dass CPUs dieser Generationen allesamt Funktionen haben, die auch virtualisiert funktionieren (AES, nested virtualization...).

Das selbe Drama hatten wir auch schon, als irgendwann die Unterstützung für 486 zurück ging, wo man nie sicher sein konnte, ob eine FPU vorhanden ist. Und irgendwann haben wir auch 32 Bit-CPUs deprecated, das tat aber weniger weh, weil man ja auch gleichzeitig mehr RAM haben wollte der mit 32 Bit schlicht nicht adressierbar war.

Jetzt schicken wir halt die Hardware in Rente, die kein AVX512 kann.

@aqui ist sowas von Streber ... !

Was ist der Sinn von den Anforderungen? Nun - mal damit angefangen das es beim Testen eben nur eine gewisse Hardware-Auswahl geben kann. Willst du wirklich noch jedes System auf nem Intel Pentium 2, 3 o. 4 testen - weils ggf. jemand nutzen will? Wenns darunter geht - gut, wenn aber dann nicht oder unstabil dann bist du eben selbst auch verantwortlich. Dazu kommt: Wenn die heute sagen würden "ok, wir nehmen auch ne ältere CPU" - wie lang soll die in einer Serie mitgeschleppt werden? Du würdest ja kaum begeistert sein wenn dein teuer gekaufter Server in 1-2 Jahren dann nachm Update nich mehr läuft...

Wenn du mal guckst - an sich hat MS hier sogar endlich mal aus der Vergangenheit gelernt... Wie lang haben die im Hintergrund noch nen "Dos"-System mitgeschliffen damit eben das OS noch zu irgendwelcher Uralt-Software kompatibel war? Und sich gewundert das der Mischbetrieb irgendwie nie so wirklich stabil gelaufen ist?

Wenn du mal guckst - an sich hat MS hier sogar endlich mal aus der Vergangenheit gelernt... Wie lang haben die im Hintergrund noch nen "Dos"-System mitgeschliffen damit eben das OS noch zu irgendwelcher Uralt-Software kompatibel war? Und sich gewundert das der Mischbetrieb irgendwie nie so wirklich stabil gelaufen ist?

Ich würde mal _vermuten_ (genau weiss es ja nur MS): Wie lang läuft nen Client-OS normalerweise? Da redet man ja im Vergleich zu Servern nur über nen sehr begrenzten Zeitraum. Gleichzeitig ist aber die Anforderung an das Client-OS deutlich komplexer - du musst ja erwarten das der Anwender vom Spielen bis zum Arbeiten alles macht. Und was würdest du als Hersteller jetzt machen - entweder setzt du zwingend vorraus das eben die Hardware genug resourcen bietet ODER du bist ggf. der Depp weil ja mit der Vorgänger-Version das Programm/Spiel/... noch viel schneller lief.

Dazu könnte ich mir einfach vorstellen das eben aktuelle Funktionen (oder in näherer zukunft geplante Funktionen) natürlich auch laufen sollen.. Aufm Server wirst du ja diese ganzen KI-Funktionen eher nicht brauchen / nutzen, das Client-OS solls ja (so wie es aussieht) bekommen.

GENAU weiss es natürlich nur MS - aber am Ende ist es halt wie immer: Entweder wird sich beschwert weil zuviel erwartet wird ODER es wird sich beschwert weils am Ende nich stabil läuft bzw. zu lahm ist... Und DAS ist halt bei Client-OS noch schlimmer als beim Server. Und es liegt ja am Ende am Kunden selbst - es steht jedem Frei ein anderes OS zu nehmen...

Dazu könnte ich mir einfach vorstellen das eben aktuelle Funktionen (oder in näherer zukunft geplante Funktionen) natürlich auch laufen sollen.. Aufm Server wirst du ja diese ganzen KI-Funktionen eher nicht brauchen / nutzen, das Client-OS solls ja (so wie es aussieht) bekommen.

GENAU weiss es natürlich nur MS - aber am Ende ist es halt wie immer: Entweder wird sich beschwert weil zuviel erwartet wird ODER es wird sich beschwert weils am Ende nich stabil läuft bzw. zu lahm ist... Und DAS ist halt bei Client-OS noch schlimmer als beim Server. Und es liegt ja am Ende am Kunden selbst - es steht jedem Frei ein anderes OS zu nehmen...

also ... ich denke nicht, dass es hier um eine bessere oder schlechtere, neuere oder ältere Technologie geht, die für Programmierer oder wen auch immer sinnvoller oder einfach zu handhaben ist.

Es geht eher um einen wegen der Verbreitung von MS Windows gigantischen, volkswirtschaftlichen Schaden, der Millionen von Computern zu Elektroschrott degradiert, das natürlich auch in sehr armen Bereichen dieser Welt.

Natürlich hätte man es anders lösen können, man wollte es eben nicht. Es ist daher einmal mehr die Frage von Abhängigkeiten von anderen Ländern, bestimmten Herstellen und daraus entstehenden zwängen.

Mein Eindruck, mein rat: Es ist zu beobachten, dass immer mehr Unternehmen und auch Behörden hin zur Microsoft Cloud tendieren. LASST DIE FINGR DAVON!

Kreuzberger

Es geht eher um einen wegen der Verbreitung von MS Windows gigantischen, volkswirtschaftlichen Schaden, der Millionen von Computern zu Elektroschrott degradiert, das natürlich auch in sehr armen Bereichen dieser Welt.

Natürlich hätte man es anders lösen können, man wollte es eben nicht. Es ist daher einmal mehr die Frage von Abhängigkeiten von anderen Ländern, bestimmten Herstellen und daraus entstehenden zwängen.

Mein Eindruck, mein rat: Es ist zu beobachten, dass immer mehr Unternehmen und auch Behörden hin zur Microsoft Cloud tendieren. LASST DIE FINGR DAVON!

Kreuzberger

Nun - nur so für sich hingestellt hat das eher mit Verschwörungstheorie zu tun als mit Fakten. Denn zum einen sind in "armen" Ländern zum Teil eh veraltete Systeme im Einsatz, da findest du auch gerne noch irgendwo nen XP (oder sogar die Schreibmaschine). Denn unabhängig von den Anforderungen die MS so hat ist auch IT PERSONAL oft da eher überschaubar. Zum anderen würde ich dir ggf. bei Apple mit der Aussage noch zustimmen - neues MacOS erfordert neue Hardware die du eben auch bei Apple kaufen musst. Aber welchen Vorteil hat MS denn davon? Du kaufst den Rechner eben bei Dell, HP, selbstbau,... - nicht bei Microsoft.

Umgekehrt aber dann an dich dieselbe Frage: Wie weit zurück willst du kompatibel sein als Hersteller? Denn in deinen sog. "armen Ländern" ist das ja ggf. was anderes als hier. Wenn du da nämlich mal in Schulen o.ä. reinguckst siehst du eben auch das die Rechner die wir auf den Recyclinghof bringen dort noch gern genommen sind (ich kenne zB. einen Kollegen der regelmässig immer 2-3 alte Laptops mitnimmt um die im Heimatland der Schule zu schenken). Demnach müsste man aber bereits beim Compiler anfangen und alles noch kompatibel zum P2 oder so machen (suchs dir aus, theoretisch sogar dann noch zum x86er ohne CoPro falls da doch noch irgendwo nen 486sx rumläuft). Du würdest dich nur dann beschweren warum du das tolle neue System gekauft hast und das nicht voll genutzt wird. Und wo möchtest du überhaupt den Cut machen - müsste ein Spielehersteller dann auch noch via DirectX auf ner alten Voodoo2 Karte laufen können? Wie siehts bei Anwendungen aus - dort is es dann mittlerweile der Speicherhunger idR. (und wenn du dann kompatibel zu alten Systemen bist gibts da lustige Effekte beim Speicher...).

Jetzt drehen wir das aber mal um... MS sagt "hast ja recht" und sagt alle Systeme der letzten 10 Jahre werden unterstützt (darfst hier auch gerne ne beliebige andere Zahl nehmen). Du kaufst dein OS heute und du hast eben die mindestanforderung grad erfüllt. Das bedeutet doch auch das MS für JEDEN Patch, SP,... das weiterhin mitschleppen muss. Oder was würdest du sagen wenn es dann in 1-2 Jahren heisst "sorry, das Update xyz" gibts für deine CPU nicht mehr. Das ist natürlich erstmal auch ein Weg (Apple machts ja zB. in etwa so). Nur: DANN müsste MS auch den kompletten Weg wie Apple gehen - nur eigene Hardware funktioniert. Denn es ist ja nicht nur deine CPU, auf deinem Board dümpelt ja noch etwas mehr rum: Chipsatz, Speicher,... Und wenn MS ansonsten sagt mit "update xyz" geht deine Hardware nicht mehr - würdest du dann nicht auch wieder stehen und "Verschwörung" rufen? Denn in deinem "armen Ländern" läuft der PC ja trotzdem noch - oder warum sollten die den ersetzen solang der noch funktioniert?

Umgekehrt aber dann an dich dieselbe Frage: Wie weit zurück willst du kompatibel sein als Hersteller? Denn in deinen sog. "armen Ländern" ist das ja ggf. was anderes als hier. Wenn du da nämlich mal in Schulen o.ä. reinguckst siehst du eben auch das die Rechner die wir auf den Recyclinghof bringen dort noch gern genommen sind (ich kenne zB. einen Kollegen der regelmässig immer 2-3 alte Laptops mitnimmt um die im Heimatland der Schule zu schenken). Demnach müsste man aber bereits beim Compiler anfangen und alles noch kompatibel zum P2 oder so machen (suchs dir aus, theoretisch sogar dann noch zum x86er ohne CoPro falls da doch noch irgendwo nen 486sx rumläuft). Du würdest dich nur dann beschweren warum du das tolle neue System gekauft hast und das nicht voll genutzt wird. Und wo möchtest du überhaupt den Cut machen - müsste ein Spielehersteller dann auch noch via DirectX auf ner alten Voodoo2 Karte laufen können? Wie siehts bei Anwendungen aus - dort is es dann mittlerweile der Speicherhunger idR. (und wenn du dann kompatibel zu alten Systemen bist gibts da lustige Effekte beim Speicher...).

Jetzt drehen wir das aber mal um... MS sagt "hast ja recht" und sagt alle Systeme der letzten 10 Jahre werden unterstützt (darfst hier auch gerne ne beliebige andere Zahl nehmen). Du kaufst dein OS heute und du hast eben die mindestanforderung grad erfüllt. Das bedeutet doch auch das MS für JEDEN Patch, SP,... das weiterhin mitschleppen muss. Oder was würdest du sagen wenn es dann in 1-2 Jahren heisst "sorry, das Update xyz" gibts für deine CPU nicht mehr. Das ist natürlich erstmal auch ein Weg (Apple machts ja zB. in etwa so). Nur: DANN müsste MS auch den kompletten Weg wie Apple gehen - nur eigene Hardware funktioniert. Denn es ist ja nicht nur deine CPU, auf deinem Board dümpelt ja noch etwas mehr rum: Chipsatz, Speicher,... Und wenn MS ansonsten sagt mit "update xyz" geht deine Hardware nicht mehr - würdest du dann nicht auch wieder stehen und "Verschwörung" rufen? Denn in deinem "armen Ländern" läuft der PC ja trotzdem noch - oder warum sollten die den ersetzen solang der noch funktioniert?

Zitat von @MysticFoxDE:

Und ja, ich habe soeben bei der Installation des aktuellsten Server 2025, nicht eine einzige Warnmeldung, wegen irgendwelcher veralteten Hardware bekommen. 😖

Und ja, ich habe soeben bei der Installation des aktuellsten Server 2025, nicht eine einzige Warnmeldung, wegen irgendwelcher veralteten Hardware bekommen. 😖

Dann war die CPU wohl neu genug. Im Vergleich zu Server 2022 sind tatsächlich auch zusätzliche Anforderungen an die CPU hinzugekommen, namentlich SSE4.2 und POPCNT.

/Thomas

Zitat von @MysticFoxDE:

Jedoch verstehe ich angesichts dieser doch sehr laschen Hardwareanforderungen für den Server 2025, die von W11 umso weniger. 😔

Jedoch verstehe ich angesichts dieser doch sehr laschen Hardwareanforderungen für den Server 2025, die von W11 umso weniger. 😔

Das ganze ist in meinen Augen so ein "so viel wie nötig, so wenig wie möglich".

Mit Win11 will Microsoft die Enduser pushen um auf neue Hardware zu setzen. Eben weil fehlende Befehlssätze oder dergleichen dann einen Programmierrattenschwanz ziehen. Der kleinste gemeinsame Nenner wird angehoben.

Beim Server ist ihnen evtl. aufgefallen "Hey, dann wird ja unsere eigene Kiste gar nicht mehr supported". Ich denke, W2k25 kann auf vielen älteren CPUs weil die jetzt das "alte Zeugs" programmiertechnisch noch mitschleppen. Aber sie heben da jetzt auch schon die Einstiegsstufe mit dem Support. Wenns funktioniert, funktionierts. Wenn nicht ist's egal, weil supporten wir ja nicht.

Insgesamt also all das, was @LordGurke beschrieben hat. Nur kann man halt oft nicht das alles durchdrücken, was man durchdrücken will.

---qoute---

Aber welchen Vorteil hat MS denn davon? Du kaufst den Rechner eben bei Dell, HP, selbstbau,... - nicht bei Microsoft.

Ähm, du vergisst hierbei glaube ich, dass MS auch noch ordentlich an den OEM Lizenzen verdient, vor allem bei Business-Hardware. 😉

---/qoute---

Weil ja auch grad bei "Business Hardware" das Problem permanent auftritt, oder? Wie lang haben die meisten Firmen denn ihre Geräte so am laufen? Entweder bis die Garantie zuende ist und/oder bis die abgeschrieben ist. Aber grad in dem Umfeld wird doch eh schon relativ schnell ersetzt... Übrigens finde ich es schon lustig wie sehr hier auf "is soviel Müll" gegangen wird... warte mal, wie lang is bei Mobil-Telefonen durchschnittlich die Nutzung und die Update-Dauer?!?

---qoute---

Natürlich nur soweit es auch Sinn macht. Die aktuelle Vorgaben von Microsoft betreffend W11 machen jedoch nicht wirklich Sinn, weil wie @LordGurke es schon geschrieben hat, bei "x86-64-v4" im Wesentlichen lediglich AVX512 Support hinzugekommen ist, denn man bitte für was genau zwangsweise benötigt.

---/qoute---

Und wie siehts beim Chipsatz aus? Und allem was noch so auf dem Board rumkreucht und fleucht? Und "soweit es auch Sinn macht" -> DAS ist jetzt eine sehr flexible Aussage, oder? Das was für DICH Sinn macht wird der nächste dann ggf. nicht mehr als "Sinnvoll" sehen.

---qoute---

Na ja, wenn das die Pinguine irgendwie hinbekommen, dann sollte es auch von Microsoft machbar sein. 😉

---/quote---

Und warum ist das so? Weil du bei Linux idR nen recht generischen Kernel lädst der aber alles andere als optimiert ist. Und grad bei Linux kannst du den Vergleich sogar recht einfach machen: Nimm dir mal nen Gentoo-Linux (sofern das noch existiert) und bau das mit Standard-einstellungen. Danach mach mal nen paar Messungen. Und dann baust du das mit optimierten Einstellungen (sei es im Compiler per Flag als auch beim Kernel selbst den Kram rauswerfen den du eh nich nutzt). Und mache dann dieselben Tests nochmal. Je nach Hardware und Einstellungen hast du hier nunmal ein nennenswertes Leistungs-Plus. Nur: Dein optimierter Kernel wird (je nachdem wie weit du das treibst) eben auch nur genau auf DEINER Hardware laufen, jede andere wird den rausrotzen...

Und am Ende ist es doch einfach: Es steht jedem frei etwas anderes zu nehmen oder das alte Windows weiter zu verwenden. Ich nutze zB. schon seid ca. 10 Jahren MacOS + Linux (auf Servern - allerdings zugegeben sind die auch eher keine Fileserver oder ähnliches was via AD sinnvoll wäre). Und wenns wirklich ein "Milliionen-Schaden" ist - warum gehen die Firmen dann den Weg? Speziell in DE höre ich eher von Firmen "wir müssen sparen" - und da wäre das ja ne leichte Option etwas Geld zu sparen...

Aber welchen Vorteil hat MS denn davon? Du kaufst den Rechner eben bei Dell, HP, selbstbau,... - nicht bei Microsoft.

Ähm, du vergisst hierbei glaube ich, dass MS auch noch ordentlich an den OEM Lizenzen verdient, vor allem bei Business-Hardware. 😉

---/qoute---

Weil ja auch grad bei "Business Hardware" das Problem permanent auftritt, oder? Wie lang haben die meisten Firmen denn ihre Geräte so am laufen? Entweder bis die Garantie zuende ist und/oder bis die abgeschrieben ist. Aber grad in dem Umfeld wird doch eh schon relativ schnell ersetzt... Übrigens finde ich es schon lustig wie sehr hier auf "is soviel Müll" gegangen wird... warte mal, wie lang is bei Mobil-Telefonen durchschnittlich die Nutzung und die Update-Dauer?!?

---qoute---

Natürlich nur soweit es auch Sinn macht. Die aktuelle Vorgaben von Microsoft betreffend W11 machen jedoch nicht wirklich Sinn, weil wie @LordGurke es schon geschrieben hat, bei "x86-64-v4" im Wesentlichen lediglich AVX512 Support hinzugekommen ist, denn man bitte für was genau zwangsweise benötigt.

---/qoute---

Und wie siehts beim Chipsatz aus? Und allem was noch so auf dem Board rumkreucht und fleucht? Und "soweit es auch Sinn macht" -> DAS ist jetzt eine sehr flexible Aussage, oder? Das was für DICH Sinn macht wird der nächste dann ggf. nicht mehr als "Sinnvoll" sehen.

---qoute---

Na ja, wenn das die Pinguine irgendwie hinbekommen, dann sollte es auch von Microsoft machbar sein. 😉

---/quote---

Und warum ist das so? Weil du bei Linux idR nen recht generischen Kernel lädst der aber alles andere als optimiert ist. Und grad bei Linux kannst du den Vergleich sogar recht einfach machen: Nimm dir mal nen Gentoo-Linux (sofern das noch existiert) und bau das mit Standard-einstellungen. Danach mach mal nen paar Messungen. Und dann baust du das mit optimierten Einstellungen (sei es im Compiler per Flag als auch beim Kernel selbst den Kram rauswerfen den du eh nich nutzt). Und mache dann dieselben Tests nochmal. Je nach Hardware und Einstellungen hast du hier nunmal ein nennenswertes Leistungs-Plus. Nur: Dein optimierter Kernel wird (je nachdem wie weit du das treibst) eben auch nur genau auf DEINER Hardware laufen, jede andere wird den rausrotzen...

Und am Ende ist es doch einfach: Es steht jedem frei etwas anderes zu nehmen oder das alte Windows weiter zu verwenden. Ich nutze zB. schon seid ca. 10 Jahren MacOS + Linux (auf Servern - allerdings zugegeben sind die auch eher keine Fileserver oder ähnliches was via AD sinnvoll wäre). Und wenns wirklich ein "Milliionen-Schaden" ist - warum gehen die Firmen dann den Weg? Speziell in DE höre ich eher von Firmen "wir müssen sparen" - und da wäre das ja ne leichte Option etwas Geld zu sparen...

Ich verstehe den ganzen Wirbel nicht. Die meisten, wenn nicht alle, Hersteller legen irgendwelche Systemvoraussetzungen für Ihre Software fest. Damit reduzieren die dann die Supportanfragen schon von vorn herein, in dem die alles filtern und abweisen können, was nicht den genannten Vorausetzungen entspricht.

"Diese Tüte eignet sich nicht als Spielzeug für Kinder unter 6 Jahren." ist auch sowas.

"Das ist doch Quatsch!", kann man sagen. "Die Kleine kann wunderbar damit spielen ..."

"Diese Tüte eignet sich nicht als Spielzeug für Kinder unter 6 Jahren." ist auch sowas.

"Das ist doch Quatsch!", kann man sagen. "Die Kleine kann wunderbar damit spielen ..."

Sehe ich halt ähnlich - daher auch die Mobil-Telefone, Tablets usw... Das sind mittlerweile ja typische "Wegwerfgeräte", selbst wenn man wollte ist nach nem Update was auf dem Telefon nich mehr supportet wird oft ja das die Anwendungen dann auch wegfallen (vgl. Whatsapp). Beim Rechner kann man eben zumindest die Software für gewöhnlich weiter verwenden...

Und ja - natürlich ist es blöd für Leute die sich dann was neues kaufen müssen. Und - so what? Errinnert sich noch einer daran das es mal ohne irgendwelche "Umweltplaketten" ging in die Städte reinzufahren? Wieviele Autos wurden da zu "Müll" (also dann eben in den Ostblock bzw. nach Afrika verschifft wo es sowas nicht gibt)? Umstellungen im IT Bereich (Modem - ISDN - DSL - ....) - wieviele Geräte wurden da immer gleich zu Schrott weils eben nen technologiewechsel gab? (Und wo wir doch beim Umwelt-Gedanken sind: Müssten dann nicht die Personen auch aufs Streaming verzichten und ganz normales Radio/TV gucken? Denn auch diese Daten müssen übertragen werden - und die Resourcen die dafür drauf gehen sind auch nicht unerheblich).

Man kann sogar einfach mal ins "kleinere" gucken - wer von euch hat weniger als 5 verschiedene Ladegeräte/Netzteile/... aufm Schreibtisch liegen? Und das nur für den "täglichen Wahnsinn" - weil das eine eben USB, dann USB-C... der nächste hat nen ganz eigenen Stecker,...

Von daher: Ja, Umweltmässig kann man sicher noch EINIGES machen - und auch aus "Finanzsicht" (denn ich brauche zB. ja nicht jedesmal nen USB-Charger, der dann eh nur in die Ecke fliegt)... Da ist als MS ganz sicher nicht das einzige schwarze Schaf, ich würde behaupten es gibt eher wenig "weisse" Schafe in der Herde...

Und ja - natürlich ist es blöd für Leute die sich dann was neues kaufen müssen. Und - so what? Errinnert sich noch einer daran das es mal ohne irgendwelche "Umweltplaketten" ging in die Städte reinzufahren? Wieviele Autos wurden da zu "Müll" (also dann eben in den Ostblock bzw. nach Afrika verschifft wo es sowas nicht gibt)? Umstellungen im IT Bereich (Modem - ISDN - DSL - ....) - wieviele Geräte wurden da immer gleich zu Schrott weils eben nen technologiewechsel gab? (Und wo wir doch beim Umwelt-Gedanken sind: Müssten dann nicht die Personen auch aufs Streaming verzichten und ganz normales Radio/TV gucken? Denn auch diese Daten müssen übertragen werden - und die Resourcen die dafür drauf gehen sind auch nicht unerheblich).

Man kann sogar einfach mal ins "kleinere" gucken - wer von euch hat weniger als 5 verschiedene Ladegeräte/Netzteile/... aufm Schreibtisch liegen? Und das nur für den "täglichen Wahnsinn" - weil das eine eben USB, dann USB-C... der nächste hat nen ganz eigenen Stecker,...

Von daher: Ja, Umweltmässig kann man sicher noch EINIGES machen - und auch aus "Finanzsicht" (denn ich brauche zB. ja nicht jedesmal nen USB-Charger, der dann eh nur in die Ecke fliegt)... Da ist als MS ganz sicher nicht das einzige schwarze Schaf, ich würde behaupten es gibt eher wenig "weisse" Schafe in der Herde...

Ich werfe auch mal meine fünf Pfennige in den Ring:

- Was soll Microsoft davon haben?

Das ist ein möglicherweise viel zu verengter Blick. Es mag durchaus sein, dass Microsoft bei isolierter Betrachtung keinen erkennbaren Vorteil davon haben könnte. Aber wie sieht das mit den nennenswerten Eigentümern von Microsoft aus, die "ganz zufällig" auch nennenswerter Eigentümer von Hardwareherstellern sind. Ist das unter dem Strich nicht dasselbe wie bei Apple? Nur ist das gerissener, weil ein Normalo das auf den ersten, zweiten, dritten Blick nicht auf dem Schirm hat.

- Nutzungsdauer von Hardware?

Ich nehme hier im Forum bei den Kommentatoren schon seit Jahren - auch in dieser Runde wieder - die Aussage zur Kenntnis, dass in Unternehmen die Hardware nach Ablauf der Garantie oder der Abschreibungszeit routinemäßig ausgetauscht wird. Das scheint ein regelrechter Branchenbrauch zu sein, der - wie ein alter Zopf - sorgfältig gepflegt wird. Möglicherweise ist aber das bereits sinnfrei beziehungsweise von ganz vielen Missverständnissen getragen. Unter Nachhaltigkeitsgesichtspunkten ist es meist sogar grober Unfug.

Nur ein kleines Beispiel: Abschreibungszeitraum. Dieser wird in Deutschland regelmäßig von den AfA-Tabellen (oder sonstigen Bilanzierungsregeln) bestimmt. Was das aber steuerrechtlich vs. (betriebs)wirtschaftlich wirklich bedeutet / meint beziehungsweise wie diesbezüglich zu differenzieren ist, dürften die meisten verkennen.

Und diese Missverständnisse werden natürlich auch von den Herstellern gepflegt, um die nächste Umsatzrunde in den gesättigten Markt drücken zu können, obschon eigentlich gar kein Erneuerungsbedarf besteht.

@maretz übersieht in diesem Zusammenhang bei seiner Argumentationslinie in Bezug auf den Linux-Kernel, dass dort das Prinzip von nachladbaren Modulen besteht. Dadurch muss nicht sofort alles im Kernel enthalten sein, wenngleich bei individuellem Bedarf benötigte Module - und mag es nur temporär während der Ausführung einer bestimmten Aufgabe sein - nachladbar sind. Diese Module dürften regelmäßig einen gewissen Optimierungsgrad aufweisen. Ein ähnliches Prinzip ist das Laden von Hardwaretreibern. All das gibt eine hohe Flexibilität bei der Nutzung von Hardware und ist alltägliche Nutzungspraxis - sowohl bei Linux als auch bei Windows.

Diese Modularität kann die Frage danach, was sinnvoll ist, ganz überwiegend objektivieren und somit von subjektiven Sichtweisen abkoppeln. Beispiel: Verschlüsselung. Ist keine spezielle AES-Einheit/-Befehlssatz vorhanden, können die erforderlichen Berechnungen fraglos in Software abgebildet werden. Jedoch ist die softwaregestützte Umsetzung bei Echtzeitanwendungen wie VPN dann nicht mehr darstellbar, wenn damit die erforderlichen Datendurchsätze etc. nicht mehr hinreichend realisierbar sind.

Die dann verbleibende Frage ist, wird eine konkrete Befehlssatz-/Spezialeinheiten-Erweiterung wirklich benötigt oder wird hier nur wieder irgendein Schnickschnack als neue Sau durchs Dorf getrieben, um irgendwelche "Bedürfnisse" und Umsatzsteigerungen zu generieren. Diese parallele Frage würde sich auch ganz anders beantworten lassen, wenn die IT-Branche nicht profitgetrieben, sondern daran orientiert wäre, was uns insgesamt wirklich voranbringen könnte. Möglicherweise wäre dann der Modularisierungsgedanke viel tiefgründiger und konsequenter verwirklicht. Nur ist das in einem destruktiven Wirtschaftssystem wie dem unseren nicht wirklich denkbar und erwartbar.

Nochmals zur Nutzungsdauer. Woher soll genommen werden, wie lange von wem - betrieblich oder privat - welche Soft- und Hardware benutzt wird? Wo sind die belastbaren Statistiken? Kann ein iPhone-Jünger, der sich bei Erscheinen eines jeden neuen iPhones schon zwei Tage vorher vor der Ladentür anstellt, um wirklich der erste zu sein, der es ergattert, das Maß für die Frage der Nutzungsdauer sein? (Freilich hätte es Apple gern, wenn alle iPhone-Nutzer "so bekloppt" wären.)

- Die Frage von @MysticFoxDE: Macht eine unterschiedliche Handhabung der Hardwareanforderungen für Server und Desktop bei derselben BS-Version einen Sinn?

Aus meiner Sicht ganz klar: Nein! Siehe Linux, wo sich Server und Desktop derselben BS-Version einer Distribution eigentlich nur darin unterscheiden, was zu Beginn standardmäßig installiert wird. Danach kann ein Server zum Desktop aufgebohrt und ein Desktop zum Core-Server minimalisiert werden. Das ist bei Windows bisher undenkbar.

Alles das, was als Differenzierung von Server und Desktop bei Windows propagiert wird, dient - gerade im Vergleich mit vorstehenden Beschreibung bei Linux - nur der Rechtfertigung der Profitsteigerung. Und das ist bei einem profitgetriebenen Unternehmen wie Microsoft ganz gewiss keine Verschwörungstheorie, sondern schlichtes Allgemeinverständnis, auch wenn es vielleicht nicht häufig formuliert werden sollte.

Viele Grüße

HansDampf06

- Was soll Microsoft davon haben?

Das ist ein möglicherweise viel zu verengter Blick. Es mag durchaus sein, dass Microsoft bei isolierter Betrachtung keinen erkennbaren Vorteil davon haben könnte. Aber wie sieht das mit den nennenswerten Eigentümern von Microsoft aus, die "ganz zufällig" auch nennenswerter Eigentümer von Hardwareherstellern sind. Ist das unter dem Strich nicht dasselbe wie bei Apple? Nur ist das gerissener, weil ein Normalo das auf den ersten, zweiten, dritten Blick nicht auf dem Schirm hat.

- Nutzungsdauer von Hardware?

Ich nehme hier im Forum bei den Kommentatoren schon seit Jahren - auch in dieser Runde wieder - die Aussage zur Kenntnis, dass in Unternehmen die Hardware nach Ablauf der Garantie oder der Abschreibungszeit routinemäßig ausgetauscht wird. Das scheint ein regelrechter Branchenbrauch zu sein, der - wie ein alter Zopf - sorgfältig gepflegt wird. Möglicherweise ist aber das bereits sinnfrei beziehungsweise von ganz vielen Missverständnissen getragen. Unter Nachhaltigkeitsgesichtspunkten ist es meist sogar grober Unfug.

Nur ein kleines Beispiel: Abschreibungszeitraum. Dieser wird in Deutschland regelmäßig von den AfA-Tabellen (oder sonstigen Bilanzierungsregeln) bestimmt. Was das aber steuerrechtlich vs. (betriebs)wirtschaftlich wirklich bedeutet / meint beziehungsweise wie diesbezüglich zu differenzieren ist, dürften die meisten verkennen.

Und diese Missverständnisse werden natürlich auch von den Herstellern gepflegt, um die nächste Umsatzrunde in den gesättigten Markt drücken zu können, obschon eigentlich gar kein Erneuerungsbedarf besteht.

@maretz übersieht in diesem Zusammenhang bei seiner Argumentationslinie in Bezug auf den Linux-Kernel, dass dort das Prinzip von nachladbaren Modulen besteht. Dadurch muss nicht sofort alles im Kernel enthalten sein, wenngleich bei individuellem Bedarf benötigte Module - und mag es nur temporär während der Ausführung einer bestimmten Aufgabe sein - nachladbar sind. Diese Module dürften regelmäßig einen gewissen Optimierungsgrad aufweisen. Ein ähnliches Prinzip ist das Laden von Hardwaretreibern. All das gibt eine hohe Flexibilität bei der Nutzung von Hardware und ist alltägliche Nutzungspraxis - sowohl bei Linux als auch bei Windows.

Diese Modularität kann die Frage danach, was sinnvoll ist, ganz überwiegend objektivieren und somit von subjektiven Sichtweisen abkoppeln. Beispiel: Verschlüsselung. Ist keine spezielle AES-Einheit/-Befehlssatz vorhanden, können die erforderlichen Berechnungen fraglos in Software abgebildet werden. Jedoch ist die softwaregestützte Umsetzung bei Echtzeitanwendungen wie VPN dann nicht mehr darstellbar, wenn damit die erforderlichen Datendurchsätze etc. nicht mehr hinreichend realisierbar sind.

Die dann verbleibende Frage ist, wird eine konkrete Befehlssatz-/Spezialeinheiten-Erweiterung wirklich benötigt oder wird hier nur wieder irgendein Schnickschnack als neue Sau durchs Dorf getrieben, um irgendwelche "Bedürfnisse" und Umsatzsteigerungen zu generieren. Diese parallele Frage würde sich auch ganz anders beantworten lassen, wenn die IT-Branche nicht profitgetrieben, sondern daran orientiert wäre, was uns insgesamt wirklich voranbringen könnte. Möglicherweise wäre dann der Modularisierungsgedanke viel tiefgründiger und konsequenter verwirklicht. Nur ist das in einem destruktiven Wirtschaftssystem wie dem unseren nicht wirklich denkbar und erwartbar.

Nochmals zur Nutzungsdauer. Woher soll genommen werden, wie lange von wem - betrieblich oder privat - welche Soft- und Hardware benutzt wird? Wo sind die belastbaren Statistiken? Kann ein iPhone-Jünger, der sich bei Erscheinen eines jeden neuen iPhones schon zwei Tage vorher vor der Ladentür anstellt, um wirklich der erste zu sein, der es ergattert, das Maß für die Frage der Nutzungsdauer sein? (Freilich hätte es Apple gern, wenn alle iPhone-Nutzer "so bekloppt" wären.)

- Die Frage von @MysticFoxDE: Macht eine unterschiedliche Handhabung der Hardwareanforderungen für Server und Desktop bei derselben BS-Version einen Sinn?

Aus meiner Sicht ganz klar: Nein! Siehe Linux, wo sich Server und Desktop derselben BS-Version einer Distribution eigentlich nur darin unterscheiden, was zu Beginn standardmäßig installiert wird. Danach kann ein Server zum Desktop aufgebohrt und ein Desktop zum Core-Server minimalisiert werden. Das ist bei Windows bisher undenkbar.

Alles das, was als Differenzierung von Server und Desktop bei Windows propagiert wird, dient - gerade im Vergleich mit vorstehenden Beschreibung bei Linux - nur der Rechtfertigung der Profitsteigerung. Und das ist bei einem profitgetriebenen Unternehmen wie Microsoft ganz gewiss keine Verschwörungstheorie, sondern schlichtes Allgemeinverständnis, auch wenn es vielleicht nicht häufig formuliert werden sollte.

Viele Grüße

HansDampf06

Zitat von @kreuzberger:

Nunja, wem hunderttausende Tonnen sinnlos erzeugter Elektroschrott egal ist, dem ist nichts hinzuzufügen.

Kreuzberger

Ich verstehe den ganzen Wirbel nicht.

Nunja, wem hunderttausende Tonnen sinnlos erzeugter Elektroschrott egal ist, dem ist nichts hinzuzufügen.

Kreuzberger

Nun - allein fürs Streaming von Videos (Youtube, Netflix,...) dürften täglich einige tonnen CO2 durch Energieverbrauch erzeugt werden. Willst du mir jetzt erzählen das es NÖTIG ist? Mit dem Unterschied das eben auch nen Rechner ja nicht einfach so in die Ecke geworfen wird - mittlerweile haben Hersteller auch erkannt das die Edelmetalle durchaus durch Recycling sinnvoll wieder rausgeholt werden können, die o.g. Energie geht eben nicht. Wenn du dann noch überlegst was so an resourcen drauf gehen damit du eben morgen irgendwo aufm letzten Furz (zumindest in den meisten Breitengraden und in besiedelten Gebieten) Internet hast sollte man sich da schon was überlegen. Oder glaubst du die Starlink-Satelliten werden zB. mit Brieftauben hochgeschickt?

Also - wo ziehst du die Grenze ab wann die "Verschmutzung" akzeptabel ist?

Also die einzige Frage sich sich hier wirklich stellt ist:

Da es Microsoft ist, wage ich hier nur mal eine These:

Alternativ:

Passt doch, wir können doch erstmal eine Generation abwarten was Microsoft sich mit dem neuen Server so alles hat einfallen lassen...

Grüße

ToWa

- Warum lässt Microsoft Server 2025 eine Installation auf einer nicht offiziell unterstützten Plattform zu?

Da es Microsoft ist, wage ich hier nur mal eine These:

- Weil Microsoft Server nur Personen installieren sollten, die sich grundlegend mit Systemanforderungen auseinandersetzen und damit ggf. später auch Rückschlüsse ziehen können warum etwas nicht funktioniert.

Alternativ:

- Der Microsoft Support möchte einfach nur mit "not supportet" bei alten Systemen antworten können.

Passt doch, wir können doch erstmal eine Generation abwarten was Microsoft sich mit dem neuen Server so alles hat einfallen lassen...

Grüße

ToWa

@hansdampf: Nen Quote erspare ich mir mal eben - da es sonst unübersichtlich wird.

a) Nutzungsdauer von Hardware: Gebe ich dir generell recht - nur weil etwas aus der Garantie ist muss es nicht gleich weggeworfen werden. Nur man kann eben auch nich immer warten bis es kaputt geht - da dann natürlich der Austausch richtig Geld kostet. Speziell bei Leuten die nicht immer im Office sind... Dazu kommt das es bei Firmengeräten ja oft genug so ist das der Mitarbeiter sich beschwert (viel zu lahm, ...).

b) Kernel: Nein, ich vergesse nicht das die als Module nachgeladen werden können. Ändert aber auch nix - denn ob du jetzt etwas direkt im Kernel hast oder als Modul nachlädst, es MUSS passend übersetzt worden sein. Wenn du - als einfaches Beispiel - den Intel ISSE-Befehltsatz vorgibst dann läuft das nicht aufm AMD (sofern die nicht 100% Kompatibel sind, ISSE is ja schon etwas her ;) ). Ob du da Module lädst oder nicht spielt gar keine Rolle. Und wenn wir deinen Ansatz nehmen und sagen "hey, wir laden einfach nach" (für dein Beispiel VPN ja durchaus machbar, sofern nicht optimiert): Dann überlege bitte für wen Windows erstellt wird - das sind zu 99% eben KEINE IT-Leute. Da muss es mit "weiter, weiter, weiter, Fertig stellen" installiert sein.

Was deine Unterscheidung zwischen Client und Server anbelangt würde ich das ebenfalls anders sehen. Einen der offentsichtlichen Unterschiede hast du bei Windows (zumindest den letzten Versionen die ich gesehen hatte - is schon nen paar Tage her) automatisch drin. Ein SERVER erwartet eher Hintergrunddienste und braucht damit nen ganz anderen Scheduler als ein Client der die Vordergrundanwendung priorisieren soll... Ein SERVER braucht ein anderes Speichermanagement (speziell wenn der Admin nicht nur mit "viel hilft viel" arbeitet) während ein Client eben auch da auf vordergrundanwendung optimiert sein sollte. Einen SERVER willst du auch nicht alle 3 Tage neustarten weil irgendwo der Speicher wieder voll ist - bei nem Client ist das idR. nichts so ungewöhnliches (und ja, jetzt kommen hier wieder "aber mein client läuft ja schon 20 Monate durch..." wo is da eigentlich der Umweltgedanke?). Bei Linux ist es nicht soo viel anders, das System wurde halt als "Server" aufgebaut und das ganze graphische Geraffel eben rangeklebt (das es gut läuft - keine Frage). Aber das es eben nicht völlig integriert ist merkt man schon wenn man an einige System-Funktionen ran will und feststellt "huch, geht doch nich sooo einfach". Und bitte nicht falsch verstehen... man KANN die Systeme natürlich auch jeweils andersrum nutzen - du kannst ja auch an nem Win Server 2022 Word installieren und dort arbeiten. Ob das wirklich zielführend ist - das ist eine andere Frage...

a) Nutzungsdauer von Hardware: Gebe ich dir generell recht - nur weil etwas aus der Garantie ist muss es nicht gleich weggeworfen werden. Nur man kann eben auch nich immer warten bis es kaputt geht - da dann natürlich der Austausch richtig Geld kostet. Speziell bei Leuten die nicht immer im Office sind... Dazu kommt das es bei Firmengeräten ja oft genug so ist das der Mitarbeiter sich beschwert (viel zu lahm, ...).

b) Kernel: Nein, ich vergesse nicht das die als Module nachgeladen werden können. Ändert aber auch nix - denn ob du jetzt etwas direkt im Kernel hast oder als Modul nachlädst, es MUSS passend übersetzt worden sein. Wenn du - als einfaches Beispiel - den Intel ISSE-Befehltsatz vorgibst dann läuft das nicht aufm AMD (sofern die nicht 100% Kompatibel sind, ISSE is ja schon etwas her ;) ). Ob du da Module lädst oder nicht spielt gar keine Rolle. Und wenn wir deinen Ansatz nehmen und sagen "hey, wir laden einfach nach" (für dein Beispiel VPN ja durchaus machbar, sofern nicht optimiert): Dann überlege bitte für wen Windows erstellt wird - das sind zu 99% eben KEINE IT-Leute. Da muss es mit "weiter, weiter, weiter, Fertig stellen" installiert sein.

Was deine Unterscheidung zwischen Client und Server anbelangt würde ich das ebenfalls anders sehen. Einen der offentsichtlichen Unterschiede hast du bei Windows (zumindest den letzten Versionen die ich gesehen hatte - is schon nen paar Tage her) automatisch drin. Ein SERVER erwartet eher Hintergrunddienste und braucht damit nen ganz anderen Scheduler als ein Client der die Vordergrundanwendung priorisieren soll... Ein SERVER braucht ein anderes Speichermanagement (speziell wenn der Admin nicht nur mit "viel hilft viel" arbeitet) während ein Client eben auch da auf vordergrundanwendung optimiert sein sollte. Einen SERVER willst du auch nicht alle 3 Tage neustarten weil irgendwo der Speicher wieder voll ist - bei nem Client ist das idR. nichts so ungewöhnliches (und ja, jetzt kommen hier wieder "aber mein client läuft ja schon 20 Monate durch..." wo is da eigentlich der Umweltgedanke?). Bei Linux ist es nicht soo viel anders, das System wurde halt als "Server" aufgebaut und das ganze graphische Geraffel eben rangeklebt (das es gut läuft - keine Frage). Aber das es eben nicht völlig integriert ist merkt man schon wenn man an einige System-Funktionen ran will und feststellt "huch, geht doch nich sooo einfach". Und bitte nicht falsch verstehen... man KANN die Systeme natürlich auch jeweils andersrum nutzen - du kannst ja auch an nem Win Server 2022 Word installieren und dort arbeiten. Ob das wirklich zielführend ist - das ist eine andere Frage...

Zitat von @maretz:

a) Nutzungsdauer von Hardware: Gebe ich dir generell recht - nur weil etwas aus der Garantie ist muss es nicht gleich weggeworfen werden. Nur man kann eben auch nich immer warten bis es kaputt geht - da dann natürlich der Austausch richtig Geld kostet. Speziell bei Leuten die nicht immer im Office sind... Dazu kommt das es bei Firmengeräten ja oft genug so ist das der Mitarbeiter sich beschwert (viel zu lahm, ...).

Der richtige Zeitpunkt zum Austausch einer Hardware wäre relativ leicht zu bestimmen, wenn der jeweilige Hersteller anhand von Support- und Garantiefällen die statistischen Daten zur Verfügung stellen würde, aus denen sich nach regulären Berechnungsverfahren der vernünftige (betriebs)wirtschaftliche Austauschzeitpunkt ermitteln ließe. Kämen dann noch Nutzungsbesonderheiten als Daten hinzu, wäre hier einiges für die Nachhaltigkeit und Ressourcenschonung ohne Verlust von Betriebssicherheit, Komfort etc. möglich. Genau dieser objektive Austauschzeitpunkt liegt beispielsweise regelmäßig ganz weit hinter dem Abschreibungszeitpunkt.a) Nutzungsdauer von Hardware: Gebe ich dir generell recht - nur weil etwas aus der Garantie ist muss es nicht gleich weggeworfen werden. Nur man kann eben auch nich immer warten bis es kaputt geht - da dann natürlich der Austausch richtig Geld kostet. Speziell bei Leuten die nicht immer im Office sind... Dazu kommt das es bei Firmengeräten ja oft genug so ist das der Mitarbeiter sich beschwert (viel zu lahm, ...).

Dass Mitarbeiter die Unternehmensgegenstände achtlos behandeln und überdies immer das Neueste fordern, ist in vielerlei Hinsicht unserem destruktiven Wirtschaftssystem und seiner tagtäglichen (Werbe)Propagandabeschallung geschuldet. Unter dem Strich ist es ein fehlgeleitetes und missbilligungswürdiges Sozialverhalten.

b) Kernel: Dann überlege bitte für wen Windows erstellt wird - das sind zu 99% eben KEINE IT-Leute. Da muss es mit "weiter, weiter, weiter, Fertig stellen" installiert sein.

Das ist für mich eine untaugliche Alibibehauptung.Nur so als Beispiel: Anfang der 1990er Jahre waren Computerzeitschriften wie PC Praxis, c't und wie sie alle heißen noch absolut informativ und lehrreich. Es wurde nämlich sehr viel Hintergrundwissen vermittelt und das sehr detailliert. Heutzutage ist davon nur noch wenig vorhanden. Meist wirken bei genauerer Betrachtung entsprechende Artikel eher oberflächlich als tiefgründig. Stattdessen besteht vielmehr der Eindruck reiner und kritikloser Verkaufsprospekte. Das hat mit Fachjournalismus nur noch wenig zu tun.

Was will ich damit sagen? Ganz gewiss kann man nicht aus jedem Nutzer einen IT-Professor machen. Das ist auch gar nicht nötig. Es erscheint auch nicht zwingend, dass sich jeder eine Computerzeitschrift kaufen müsste. Relevant wäre stattdessen, dass die Software tatsächlich die Nutzer im Blick hätte. Dann könnte auch ein normaler Nutzer bei etwaigen Einstellungen und Optionen "ergonomisch" geführt werden. Zudem wäre es sicherlich nützlich, wenn in der breiten Masse das Bewusstsein verankert wäre, dass technische Geräte - also auch Soft- und Hardware - eine autonome Befassung erfordern, und die Bereitschaft bestünde, sich darauf lernfreudig einzulassen. Das zu vermitteln, würde aber erfordern, damit bereits im frühen Kindesalter zu beginnen - nur davon entfernen wir uns in Deutschland immer mehr ...

Was deine Unterscheidung zwischen Client und Server ... das ist eine andere Frage...

Hier hast Du mich möglicherweise missverstanden. Du weist ja selbst darauf hin, dass auf einem Windowsserver ein Office installiert und betrieben werden könnte. Würden seitens Microsoft keine Sperren eingebaut sein, so könnte spiegelbildlich auf einem Windows 11 eine DC- oder DNS-Rolle installiert werden. Das zeigt doch, dass es letztlich auf den BS-Kern ankommt, was mittels eines bestimmten Betriebssystems an Software ausführbar ist. Und dass ein Computer für seine konkrete Verwendung - ob als Server oder Desktop, ob für eine ganz bestimmte Anwendung (z.B. Datenbank) - angepasst werden muss, ist doch selbstredend. Unterschiedliche Aufgaben erfordern unterschiedliche Konfigurationen. Wer würde schon auf einem Linux-System die Anwendung Open VSwitch installieren, wenn das System nicht als Virtualisierungshost benutzt wird, was dann die Anbindung der virtuellen Maschinen an die physischen Schnittstellen erfordern würde?Am Ende wird doch die Einordnung, ob ein Computer ein Server oder ein Desktop ist, dadurch geprägt, welche Aufgaben ihm zugewiesen werden, welche Software dafür installiert ist und wie sich die tatsächliche Nutzung darstellt.

Hänge ich an einen nakten RaspPi eine Festplatte, erstelle eine Freigabe und lasse andere Netzwerkteilnehmer darauf zugreifen, so wird der RaspPi bereits zum Fileserver im netzwerkorganisatorischen Sinne, wenn sich darin seine Daseinsberechtigung erschöpft. Im weiter verstandenen Sinne macht jegliche Freigabe den jeweiligen Computer zu einem "Fileserver".

Unsere Begrifflichkeiten und deren Verständnis sind eben nicht homogen. Gerade hier besteht der Unterschied zwischen einer Linux-Distribution und Windows. Windows hat zwei vermeintlich unterschiedliche Betriebssystemevarianten und in der Windowswelt wird die Denke schon immer von dieser Zweiteilung geprägt, weil Microsoft das so vorgibt. In der Linuxwelt gibt es diese zweiteilige Denke so gerade nicht. Vielmehr heißt es dort eher: Nimm die passende Distribution und installiere (nur) das, was für die konkrete Aufgabenzuweisung benötigt wird. Ob das Linux dann ein Server oder Desktop im Sinne der Windowszweiteilung wäre, ist eigentlich völlig egal.

Viele Grüße

HansDampf06

Als. Restriktiver als. Sorry, der Pedant in mir.

Knackpunkt wird vermutlich gewesen sein, dass da dann bestimmte laufende Server betroffen gewesen wären, die aber ein Update machen sollten. Erweitert man halt entsprechend. Passiert in anderen Branchen auch laufend. Da wird eine Veränderung bei z.B. den Abrechnungsmodalitäten beschlossen und beim Testen wird dann bemerkt, dass evtl. ein wichtiger Kunde dabei rausrutscht oder so. Dann wird eben nachträglich angepasst.

Ich vermute bei Microsoft eben genau so ein internes Kommunikationsproblem. Im Management wird was beschlossen und in den Abteilungen wird dann bemerkt, dass das Quatsch ist.

Aber: man kann nur vermuten. Es ist halt so wie es ist. Nimmt man am besten als gegeben. Ändern kann man es ja nicht, nur das System wechseln.

Das macht meiner Ansicht nach überhaupt keinen Sinn, auch nicht supporttechnisch.

Macht's auch nicht. Daher glaube ich, dass die Systemanforderungen nachträglich geöffnet wurden. Beabsichtigt wurde bestimmt das gleichzusetzen. Ist einfacher und damit billiger, wenn man sich quasi nur um ein Merkmal kümmern muss.Knackpunkt wird vermutlich gewesen sein, dass da dann bestimmte laufende Server betroffen gewesen wären, die aber ein Update machen sollten. Erweitert man halt entsprechend. Passiert in anderen Branchen auch laufend. Da wird eine Veränderung bei z.B. den Abrechnungsmodalitäten beschlossen und beim Testen wird dann bemerkt, dass evtl. ein wichtiger Kunde dabei rausrutscht oder so. Dann wird eben nachträglich angepasst.

Ich vermute bei Microsoft eben genau so ein internes Kommunikationsproblem. Im Management wird was beschlossen und in den Abteilungen wird dann bemerkt, dass das Quatsch ist.

Aber: man kann nur vermuten. Es ist halt so wie es ist. Nimmt man am besten als gegeben. Ändern kann man es ja nicht, nur das System wechseln.

Ok - dem kann ich ja zustimmen. Natürlich werden diese Dinge irgendwo im Management beschlossen - und die meisten hier dürften wissen das nicht jeder Manager immer wirklich "vom Fach" ist.

Aber natürlich macht es eben auch den Support leichter - je weniger Komponenten man hat umso leichter wird es nunmal. Es geht ja nicht nur um den Support-Call weil irgendwo nen Rechner absemmelt sondern eben auch darum auf wie vielen Geräten ich zB. die Software testen muss. Warum steht wohl bei Anwendungen idR. auch nur max. 1-2 Versionen von Windows zurück - obwohl die ggf. auch auf nem Win7 laufen würde (oder sogar auf XP)? Weil der Hersteller einfach weder Zeit, Resourcen noch Geld hat (und/oder haben will) um das eben zu testen. Also schreibt man eben lieber etwas weniger auf - und wenn der Anwender dann sagt "aber geht auch so" -> ja, dann mach halt, solang ich es nicht fixen muss wenns absemmelt... Und jeder der hier eben mal im privatbereich für Freunde, Bekannte &/ Familie die Rechner macht dürfte das kennen -> da sagt man ja auch idR. "ich stells dir einmal ein das es läuft... wenn du dann meinst jeden Sch... installieren zu müssen -> ok, aber komm nich alle 3 Min und sag dann es geht nich mehr..."

Aber natürlich macht es eben auch den Support leichter - je weniger Komponenten man hat umso leichter wird es nunmal. Es geht ja nicht nur um den Support-Call weil irgendwo nen Rechner absemmelt sondern eben auch darum auf wie vielen Geräten ich zB. die Software testen muss. Warum steht wohl bei Anwendungen idR. auch nur max. 1-2 Versionen von Windows zurück - obwohl die ggf. auch auf nem Win7 laufen würde (oder sogar auf XP)? Weil der Hersteller einfach weder Zeit, Resourcen noch Geld hat (und/oder haben will) um das eben zu testen. Also schreibt man eben lieber etwas weniger auf - und wenn der Anwender dann sagt "aber geht auch so" -> ja, dann mach halt, solang ich es nicht fixen muss wenns absemmelt... Und jeder der hier eben mal im privatbereich für Freunde, Bekannte &/ Familie die Rechner macht dürfte das kennen -> da sagt man ja auch idR. "ich stells dir einmal ein das es läuft... wenn du dann meinst jeden Sch... installieren zu müssen -> ok, aber komm nich alle 3 Min und sag dann es geht nich mehr..."

Und wie machst du das am besten? Indem du ein anderes Produkt kaufst (oder völlig verzichtest, was hier aber eher unrealistisch ist). Wenn aber natürlich der Kram trotzdem weiter gekauft wird (und hier sind ja einige der "Entscheider" auch vertreten) macht der Hersteller ja alles richtig, oder? Warum unnötige Mühe in das Produkt setzen wenn der Kunde es auch so nimmt...

Zitat von @MysticFoxDE:

na ja, auf diesen Grund bin ich schon selber gekommen, daher habe ich ja auch gefragt ob jemand vielleicht noch einen anderen kennt, der auch Sinn macht und technisch auch nachvollziehbar ist. 😔

Du hast zu hohe Ansprüche na ja, auf diesen Grund bin ich schon selber gekommen, daher habe ich ja auch gefragt ob jemand vielleicht noch einen anderen kennt, der auch Sinn macht und technisch auch nachvollziehbar ist. 😔

Das ist ein Konzern, dessen einziges Ziel darin besteht, mehr Geld als vorher zu verdienen. Solche Entscheidungen kommen nicht von technischen Experten. Die treffen Führungskräfte, welche wiederum an Umsatz & Profit gemessen werden.

Wer weiterhin das Zeug kauft, lässt deren Sektkorken knallen und sendet das Signal: Oh ja daddy, gibs mir bitte noch härter!

Es ist halt so wie es ist. Nimmt man am besten als gegeben. Ändern kann man es ja nicht, nur das System wechseln.

Neeee: Ich freue mich auch immer über Spekulatius und Schokoladenweihnachtsmänner im 30°C warmen September. Das ist toll und es heisst doch immer: Die künden wollen das!

Ja, die Kunden wollen das: Sie wollen immer das neueste und die alten, schroteigen i7- und i9-PCs mit superschnellen SSDs in die Tonne schmeissen, weil sie gerade so leider nicht die Hardwareanforderung von Win11 erfüllen. Leider hat man sich auf Windows allgemein und Active Directory festgelegt, vieles davon längst in die Microsoft-Cloud ausgelagert und kann eben gar nicht mehr zurück, weil es gar keinen weg zurück mehr gibt, und alternativen kaum realisierbar sind, es sei denn man hat IT-Leute, die sich in der Linux-Welt bestens auskennen.

In kleineren bis mittleren Umgebungen wird das wohl sogar halbwegs gut ersatzweise gehen. Aber bei Umgebungen mit mehreren Tausend Compterarbeitsplätzen wird das unmöglich, komplett ohne Windows auskommen zu können.

heise.de/news/Informatiker-Deutschland-tappt-in-der-Microsoft-Cl ...

Was macht man also nächstes Jahr mit Hunderttausenden funktionierenden PCs? Und wie schnell bekommt man dann überhaupt neue PCs wenn der Markt dann vermutlich vorausschauend leer gefegt ist weil die Produktion nicht nachkommt? (Geld bezahlen an MS für längeren Support).

Wir Europäer benötigen eine Alternative.

Kreuzberger

Zitat von @MysticFoxDE:

in dem ich das eben nicht so einfach hinnehme, daher habe ich ja auch unter anderem auch diesen Beitrag geschrieben. 😉

in dem ich das eben nicht so einfach hinnehme, daher habe ich ja auch unter anderem auch diesen Beitrag geschrieben. 😉

Das beruhigt jetzt aber nur dein Gewissen. Du musst dem Verantwortlichen schon die Rückmeldung geben, dass du nicht zufrieden bist.

Wird halt bei einigen Unternehmen schwierig. Da schafft man das in der Regel nur über Verkaufszahlen.

Nur frage ich mich jetzt, was denn an der Systemanforderung das Problem konkret ist. Es geht ja dann schlussendlich ncht um den W2K25, sondern um Win11. Denn letzteres hat ja restriktivere Mindestanforderungen.

Wie willst du jetzt Microsoft wissen lassen, dass du persönlich nicht damit zufrieden bist?

Wenn du was weißt, dann lass es mich wissen. Ich mach mit. Bei Windows 11 ist es technisch nicht notwendig, da immer auf neue Hardware zu setzen, nur weil Microsoft es so will.

Auf der anderen Seite ist es jetzt aber auch nicht so, wie bei z.B. Windows 8, bei dem es weltweit einen massiven öffentlichen Widerstand (Youtube, Berichte, etc.) gab.

Zitat von @MysticFoxDE:

wie kommst du denn darauf, dass diese Hardware nicht offiziell supportet ist?

Denn im Gegensatz zu Windows 11, sehen die offiziellen Hardwareanforderungen von Server 2025 sehr bescheiden aus ...

learn.microsoft.com/en-us/windows-server/get-started/hardware-re ...

Gruss Alex

Also die einzige Frage sich sich hier wirklich stellt ist:

- Warum lässt Microsoft Server 2025 eine Installation auf einer nicht offiziell unterstützten Plattform zu?

wie kommst du denn darauf, dass diese Hardware nicht offiziell supportet ist?

Denn im Gegensatz zu Windows 11, sehen die offiziellen Hardwareanforderungen von Server 2025 sehr bescheiden aus ...

learn.microsoft.com/en-us/windows-server/get-started/hardware-re ...

Gruss Alex

Hallo Alex,

du weißt doch, bei Microsoft ist alles irgendwie verworren...

Schau mal hier: learn.microsoft.com/en-us/windows-hardware/design/minimum/window ...

Grüße

ToWa

Serie: DIE WINDOWS SERVER 2025 STORY

Windows Server 2025 - Installations-ISOs seit April um 1GB kleiner16Hyper-V 2025 - Failovercluster - neue und per Default eingerichtete Rolle - Benutzer-Manager-Gruppe5Windows Server 2025 - mal mit mal ohne Remove-WindowsFeature10Windows Server 2025 - Xeon Gold 6144 - Installationsdesaster112Windows Server 2025 - RDMA - Folge 02 - Der Intel-BIOS-Wirrgarten2Windows Server 2025 - RDMA - Folge 01 - Der Anfang des Grauens6Windows Server 2025 - Energieoptionen per GUIs nicht änderbar10Windows Server 2025 - NIC-Performance - Per Default sehr "durchwachsen"58Windows Server 2025 - HARDWAREANFORDERUNGEN - Ich habe da einige Fragen44